EU AI Act Chatbots im E-Commerce: Warum Produktberater mehr als nur einen Disclaimer brauchen

Der EU AI Act ändert die Spielregeln für KI Chatbots. Erfahre, warum E-Commerce Produktberater neben der KI-Regulierung auch Haftungsfallen beachten müssen.

Einleitung: Der EU AI Act und der Shift vom FAQ-Bot zum Produktberater

Der EU AI Act markiert einen Wendepunkt in der Regulierung künstlicher Intelligenz in Europa. Am 1. August 2024 ist dieses wegweisende Gesetz in Kraft getreten und zielt darauf ab, die Entwicklung und den Einsatz von KI-Technologien verantwortungsvoll zu gestalten. Doch für Online-Händler bedeutet dies mehr als nur juristischen Papierkram.

Während klassische Support-Bots oft nur Öffnungszeiten herunterbeten, übernehmen moderne KI-Lösungen zunehmend die Rolle von Verkäufern. Für Unternehmen, die solche intelligenten KI Chatbots einsetzen, ist das Verständnis dieser Verordnung von entscheidender Bedeutung – nicht nur wegen der Compliance, sondern um das Vertrauen der Kunden zu sichern.

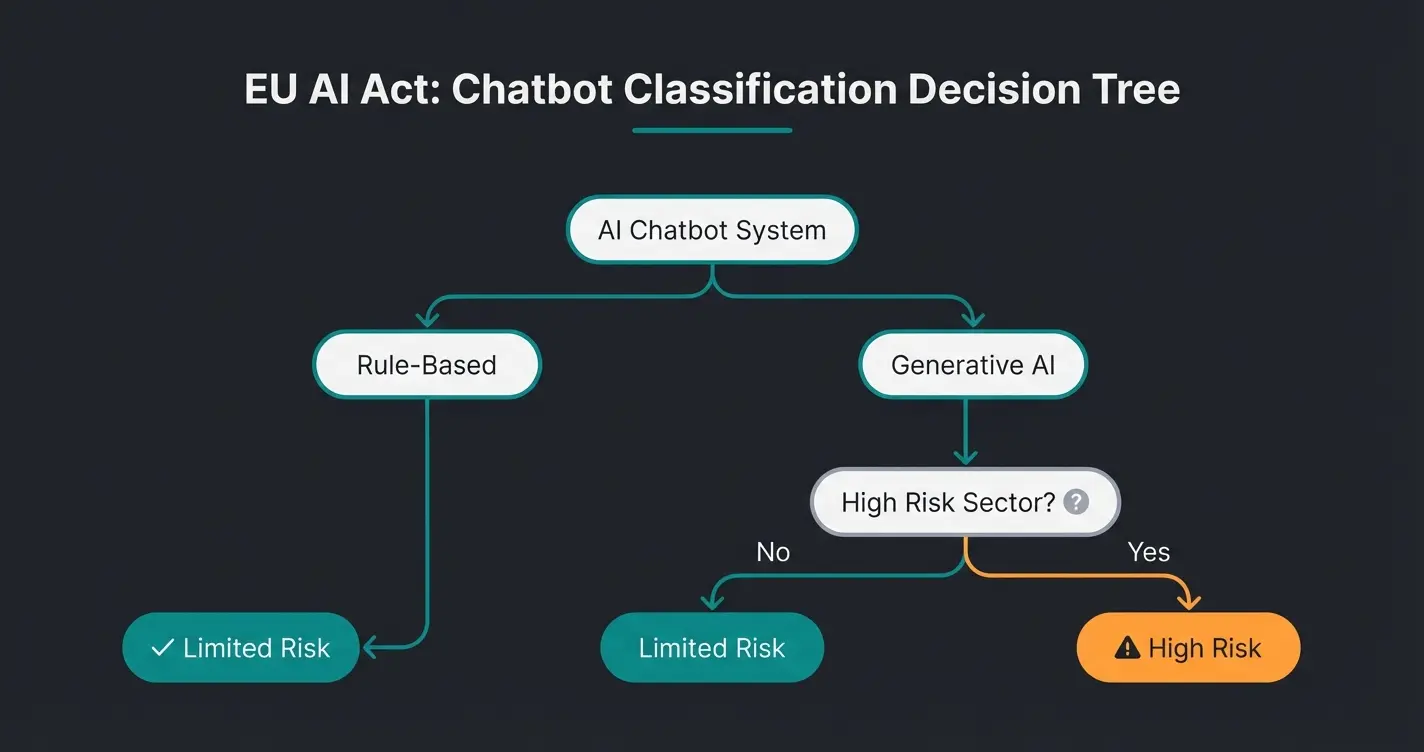

Der EU AI Act verfolgt einen risikobasierten Ansatz und kategorisiert KI-Systeme in vier Risikoklassen: unakzeptables Risiko (verboten), hohes Risiko (streng reguliert), begrenztes Risiko (Transparenzanforderungen) und minimales Risiko (unreguliert). Diese Einstufung hat weitreichende Auswirkungen auf die Entwicklung, den Einsatz und die Überwachung von KI-Systemen, einschließlich Chatbots.

Für dich als Unternehmer, der KI Chatbots in Geschäftsprozesse integriert hat oder dies plant, ist es unerlässlich, die Auswirkungen des EU AI Acts zu verstehen. Die Verordnung betrifft nicht nur Anbieter von KI-Systemen, sondern auch Nutzer, Importeure und Vertreiber innerhalb der EU oder solche, die Menschen in der EU beeinflussen. Mit potenziellen Strafen von bis zu 35 Millionen Euro oder 7% des globalen Jahresumsatzes unterstreicht der EU AI Act die Dringlichkeit der Compliance.

Was sind KI Chatbots laut EU AI Act eigentlich?

Im Rahmen des EU AI Act werden KI Chatbots als fortschrittliche Dialogsysteme betrachtet, die auf künstlicher Intelligenz basieren. Sie fallen unter die breite Definition von KI-Systemen, die im Gesetz als Software verstanden werden, die mit Techniken des maschinellen Lernens, logik- und wissensbasierten Ansätzen oder statistischen Methoden entwickelt wurde und in der Lage ist, für bestimmte von Menschen festgelegte Ziele Inhalte, Vorhersagen, Empfehlungen oder Entscheidungen zu generieren.

- Natürliche Sprachverarbeitung: Fähigkeit, menschliche Sprache zu verstehen und zu generieren

- Kontextverständnis: Analyse und Interpretation des Gesprächskontexts

- Lernfähigkeit: Kontinuierliche Verbesserung durch Interaktionen

- Personalisierung: Anpassung der Antworten an individuelle Nutzerbedürfnisse

- Autonomie: Fähigkeit, selbstständig Entscheidungen zu treffen und Antworten zu generieren

Im Gegensatz zu herkömmlichen regelbasierten Chatbots, die auf vordefinierten Skripten basieren, nutzen KI Chatbots komplexe Algorithmen und Datenanalyse, um dynamisch auf Nutzereingaben zu reagieren. Diese Fähigkeit zur adaptiven Interaktion und Entscheidungsfindung macht sie zu einem leistungsfähigen Werkzeug für den Kundenservice per KI, birgt aber auch potenzielle Risiken, die der EU AI Act adressiert.

Die Einordnung eines Chatbots als KI-System nach dem EU AI Act hängt von seiner spezifischen Funktionsweise und seinem Einsatzbereich ab. Entscheidend ist, ob der Chatbot eigenständig Inhalte generiert, Entscheidungen trifft oder Empfehlungen gibt, die über einfache vordefinierte Antworten hinausgehen.

Einordnung: Wo steht dein Chatbot in der Risikopyramide?

Der EU AI Act nimmt eine risikoorientierte Herangehensweise zur Regulierung von künstlicher Intelligenz vor. Für Betreiber von E-Commerce-Plattformen ist es essenziell zu wissen, wo ihre digitalen Assistenten stehen.

Keine Regulierung

Transparenzpflicht (Art. 50)

Strenge Auflagen & Audits

Begrenztes Risiko (Limited Risk): Hierunter fallen die meisten Standard-Chatbots für Kundenservice oder Produktberatung. Sie müssen primär Transparenzanforderungen erfüllen, etwa den Nutzer darüber informieren, dass er mit einem KI-System interagiert. Das ist die Kategorie, in der sich 90% der Online-Shops wiederfinden.

Hohes Risiko (High Risk): Chatbots könnten als hochriskant eingestuft werden, wenn sie in sensiblen Bereichen wie Gesundheitsberatung (z.B. Apotheken-Bots, die Symptome deuten) oder Finanzdienstleistungen (Kredit-Scoring) eingesetzt werden. Hier gelten strenge Auflagen bezüglich Datenschutz, Sicherheit und menschlicher Aufsicht. Die genaue Einordnung eines KI Chatbots erfordert daher immer einen Blick auf den Kontext, nicht nur auf die Technik.

Vermeide rechtliche Risiken und setze auf eine sichere Lösung für deine Produktberatung.

Jetzt Beratung startenPflichtprogramm: Die Kennzeichnungspflicht nach Artikel 50

Für Chatbots mit begrenztem Risiko ist die Transparenz das A und O. Der Nutzer muss wissen, dass er mit einer Maschine spricht. Das klingt banal, wird aber oft falsch gemacht. Ein Bild von einem lächelnden Mitarbeiter namens "Hans vom Support" zu verwenden, wenn eigentlich eine KI antwortet, ist unter dem EU AI Act (und oft auch nach dem UWG) irreführend.

Muster-Formulierungen für deinen Disclaimer

Hier sind Beispiele, wie du die Transparenzpflicht elegant lösen kannst, ohne die User Experience zu zerstören:

- Der Ehrliche: "Hallo! Ich bin der KI-Assistent von [Shop-Name]. Ich helfe dir, das richtige Produkt zu finden."

- Der Funktionale: "Automatisierter Chat: Ich beantworte Fragen zu unseren Produkten basierend auf den Herstellerdaten."

- Der Vorsichtige (am Ende): "Dieser Text wurde von einer KI generiert. Bitte prüfe wichtige Details in der Produktbeschreibung."

Die "Haftungsfalle": Wenn der Chatbot zum Verkäufer wird

Hier unterscheidet sich ein einfacher FAQ-Bot von einem echten Produktberater. Wenn dein Chatbot nicht nur sagt "Wir haben bis 18 Uhr geöffnet", sondern "Dieses Fahrrad ist für Personen über 120kg geeignet", betrittst du den Bereich der Produktberatung. Und hier lauert eine Gefahr, die viele übersehen: Die Haftung für Falschberatung.

Wenn die KI halluziniert (also Fakten erfindet) und dem Kunden eine Eigenschaft zusichert, die das Produkt nicht hat, ist das nicht nur ärgerlich, sondern ein Fall von Sachmangelhaftung oder sogar ein Verstoß gegen das Gesetz gegen den unlauteren Wettbewerb (UWG).

| Funktion | Rechtliches Risiko | Lösung / Mitigation |

|---|---|---|

| FAQ-Bot (Öffnungszeiten) | Minimal | Regelbasierte Antworten |

| Produktempfehlung | Mittel (Ungenauigkeit) | Disclaimer + Link zum Produkt |

| Technische Zusicherung | Hoch (Falschberatung) | RAG-Technologie + Quellenangabe |

Die Lösung für dieses Problem ist technisch: Retrieval Augmented Generation (RAG). Anstatt die KI frei "fabulieren" zu lassen, zwingst du sie durch RAG, nur Informationen zu nutzen, die du in deiner Datenbank (z.B. Produktdatenblättern) hinterlegt hast. Das nennt man "Grounding". Bei der Produktberatung per KI ist diese technische Leitplanke deine wichtigste Versicherung gegen Haftungsansprüche.

Leitfaden zur Einordnung eines KI Chatbots nach EU AI Act Standards

Um sicherzugehen, dass du compliant bist, solltest du diesen strukturierten Ansatz verfolgen. Dies gilt besonders, wenn du planst, deinen Bot zu skalieren.

Schritt 1: Bewertung des Einsatzbereichs

- Branche: In welchem Sektor wird der Chatbot eingesetzt? Besonders sensibel sind Bereiche wie Gesundheit, Finanzen oder öffentliche Dienste.

- Zielgruppe: Wer sind die Nutzer? Besondere Vorsicht ist geboten bei vulnerablen Gruppen wie Kindern oder älteren Menschen.

- Entscheidungsrelevanz: Welche Auswirkungen haben die Interaktionen? Führt die Empfehlung zu einem direkten Kaufabschluss oder Vertrag?

Schritt 2: Analyse der Funktionalitäten

Untersuche die spezifischen Fähigkeiten:

- Komplexität: Wie fortgeschritten sind die KI-Funktionen? Einfache regelbasierte Systeme haben ein geringeres Risiko als hochentwickelte Machine Learning Modelle.

- Autonomie: In welchem Maße trifft der Chatbot eigenständige Entscheidungen?

- Lernfähigkeit: Passt sich der Chatbot durch Interaktionen an? Kontinuierliches Lernen (ohne Reset) erhöht potenziell das Risiko unvorhergesehener Antworten.

Schritt 3: Datenschutz und Sicherheitsaspekte

Schließlich müssen Datenschutz und Sicherheit berücksichtigt werden. Die Einhaltung der EU-Datenschutzstandards (DSGVO) läuft parallel zum AI Act:

- Datenverarbeitung: Verarbeitet der Bot personenbezogene Daten um Empfehlungen zu geben?

- Datenspeicherung: Wie und wo werden die Daten gespeichert? Server in der EU sind oft Pflicht.

- Sicherheitsmaßnahmen: Welche Vorkehrungen gibt es gegen "Prompt Injection" (Hacking des Bots)?

Exkurs: Wann wird ein Chatbot zum "Hochrisiko-System"?

Auch wenn die meisten E-Commerce-Bots "Safe" sind, solltest du die Grenzen kennen. Der EU AI Act definiert Hochrisiko-Systeme dort, wo es um Lebenschancen oder Sicherheit geht.

Ein KI Chatbot wird als Hochrisiko-System eingestuft, wenn er folgende Kriterien erfüllt:

- Entscheidungsgewalt: Der Chatbot trifft autonome Entscheidungen mit erheblichen Auswirkungen auf Individuen (z.B. Ablehnung eines Kredits).

- Sensible Bereiche: Einsatz in kritischen Sektoren wie Gesundheitswesen (Diagnose-Bots), Finanzen oder Bildung.

- Persönliche Daten: Verarbeitung großer Mengen sensibler persönlicher Informationen (Biometrie etc.).

Hochrisiko-KI-Chatbots müssen strenge Anforderungen erfüllen, wie umfassende Risikoanalysen, Verwendung hochwertiger Trainingsdaten und eine lückenlose Dokumentation. Besondere Aufmerksamkeit gilt auch der digitalen Barrierefreiheit und der Vermeidung von Diskriminierung. Solltest du in diesen Bereichen tätig sein, reicht eine einfache Softwarelösung oft nicht aus – hier ist juristische Begleitung Pflicht.

Erfasse alle KI-Tools, die Kundenkontakt haben.

Prüfe: Nur Info (Limited Risk) oder kritische Entscheidung (High Risk)?

Implementiere den Transparenz-Hinweis im Chat-Fenster.

Verbinde die KI technisch mit verifizierten Produktdaten (RAG).

Fazit: Compliance als Wettbewerbsvorteil nutzen

Der EU AI Act schafft einen klaren regulatorischen Rahmen, der Innovationen fördert und gleichzeitig den Schutz der Nutzer gewährleistet. Für dich als Händler bedeutet das: Compliance ist keine Bremse, sondern ein Qualitätsmerkmal.

Ein transparenter, gut "geerdeter" Produktberater, der offen kommuniziert, dass er eine KI ist, baut mehr Vertrauen auf als ein Bot, der vorgibt, ein Mensch zu sein und dann falsche Antworten gibt. Die Zukunft von KI Chatbots unter dem EU AI Act gehört denen, die Sicherheit und Verkaufstalent technisch sauber verbinden.

Ja, der AI Act gilt unabhängig von der Unternehmensgröße. Auch kleine Shops müssen ihre Chatbots als KI kennzeichnen (Transparenzpflicht), wenn diese mit Kunden interagieren.

Dann greifen Haftungsregeln wie die Sachmangelhaftung oder Wettbewerbsrecht (UWG). Deshalb ist es wichtig, KI-Modelle technisch so einzuschränken (z.B. durch RAG), dass sie nur validierte Produktdaten nutzen.

Nein, aber du musst prüfen, ob er unter den AI Act fällt. Meistens reicht es, einen klaren Hinweis ('Ich bin ein virtueller Assistent') hinzuzufügen und sicherzustellen, dass Datenschutzstandards eingehalten werden.

Das Gesetz trat im August 2024 in Kraft. Die Regeln für 'verbotene KI' gelten ab Februar 2025, die meisten Pflichten für Chatbots (General Purpose AI) greifen schrittweise bis August 2026.

Nutze unsere Technologie für halluzinationsfreie Produktberatung, die den EU-Standards entspricht.

Kostenlos testen